‘네이버 ASF(AI Safety Framework)’라는 이름으로 발표됐는데, 지난해 11월 우리 정부도 참석한 ‘제1회 AI 안전 정상회담(AI Safety Summit 2023)’에서 합의된 ‘28개국 공동 프런티어 AI 안전성 테스트’에도 기여할 전망이다.

‘프런티어 AI’는 인간의 통제를 벗어나 스스로 생각하고 추론하며 전쟁 등에 활용될 수 있는 고도의 기능을 갖춘 AI 기초 모델을 의미한다. 세계 각국 정상들은 AI 선도기업과 학계, 각국 정부를 포함한 글로벌 협력을 강조하고 있다.

|

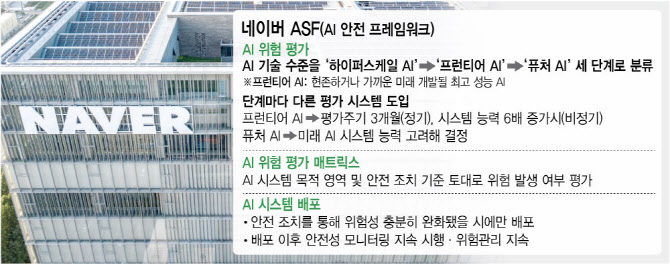

네이버가 17일 공개한 ‘네이버 ASF(AI Safety Framework)’는 AI 시스템을 개발하고 배포하는 과정에서 모든 단계에서 AI의 잠재적 위험을 통제하기 위한 내부 시스템이다. 이 프레임워크는 AI 기술 수준을 정의하고 이를 평가·관리하기 위한 기본 방향을 제시하며 위험관리를 위한 거버넌스와 외부 협업체계를 구체화했다.

이는 국내 기업 중에서는 처음으로 만들어진 AI 안전성 시스템이다. 지역 문화의 특수성을 존중하는 점과 소버린 AI가 안전성과 위험성 최소화에 필수적이라는 점을 강조한 것이 눈에 띈다.

기술 통제력 상실 대비…3개월마다 정기 평가

네이버는 AI 시스템이 초래할 수 있는 주요 위험으로 △‘통제력 상실 위험’과 △‘악용 위험’을 구분했다. 이는 AI가 지속적으로 발전함에 따라 원치 않는 전쟁 등 인간의 통제를 상실할 가능성과, 시스템이 악의적으로 사용되거나 오남용될 위험을 고려한 것이다.

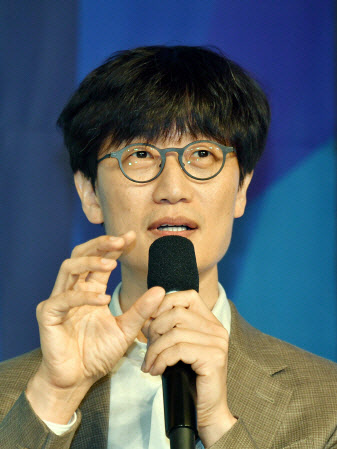

하정우 네이버 퓨처 AI센터장은 “네이버가 글로벌 AI 안전 관련 최신 노력 수준에 맞춰 국내 최초로 프런티어 AI에 대한 위험관리 실행 프레임워크인 네이버 ASF를 공개했다”며 “각 항목별 구체화 된 문서는 추후 공개 예정”이라고 밝혔다.

|

기술 악용 줄이자..안전할 때만 배포

‘악용 위험’은 AI의 기술 수준과는 관련이 없다. 그보다는 사회적으로 우려되는 영역에서 활용되거나 시스템의 목적과는 다른 악의적 사용 가능성을 의미한다.

네이버 ASF에서는 이러한 위험을 막기 위해 ‘AI 위험 평가 매트릭스’를 도입하여 AI 시스템의 목적 영역과 안전 조치의 필요성을 기준으로 위험 여부를 평가한다.

‘다양성 보장 없으면 AI 위험’…소버린AI에도 접목

네이버는 한국 외 다른 지역의 정부 및 기업과 소버린 AI를 공동 개발하며, 특정 문화권에서 성립될 수 있는 AI 시스템의 위험을 식별하고 위험의 정도를 측정하는 벤치마크도 문화권의 특성을 반영해 고도화한다는 계획이다. 여기엔 AI에 다양성이 보장되지 않을 경우 안전을 담보할 수 없다는 인식이 깔려 있다.

네이버 창업자인 이해진 글로벌투자책임자(GIO)도 지난달 21일 비공개로 진행된 ‘AI 서울 정상회의’ 정상 세션에서 소버린 AI 중요성을 강조하며 “극소수 AI가 현재를 지배하게 되면 과거 역사·문화에 대한 인식은 해당 AI의 답으로만 이뤄지게 되고 결국 미래까지 해당 AI가 큰 영향을 미치게 된다. 다양한 AI 모델들이 많이 나와야 한다”고 강조했다.

올해 초 AI 연구 및 정책조직인 ‘퓨처 AI센터’를 설립하는 등 글로벌 차원에서의 AI 안전성 연구를 이어온 네이버는 두 차례 열린 AI 정상회의에 글로벌 기업들과 함께 참가하며 이 같은 노력을 인정받았다.

글로벌 빅테크들이 참가해 AI 안전성 연구 및 레드팀 운영 관련 협력을 논의한 AI 정상회의에 국내 기업 중엔 네이버와 삼성전자만 두 번 모두 참석했다.

하정우 센터장은 “네이버는 하이퍼클로바X를 개발, 배포, 서비스 제품화하고 생태계에 응용프로그램인터페이스(API)로 제공함에 있어 안전성을 강화하기 위한 연구뿐 아니라 정책 프레임워크까지 한국 AI 국가대표로서 노력하고 있다”면서 “네이버 ASF는 생성형 AI 시대를 대비해 수립된 안전성 검증 프로토콜로, 이를 통해 글로벌 커뮤니티와의 협력을 강화하고 AI 안전성 분야에서 리더십을 강화할 것”이라고 했다.

![월드컵까지 따냈다...스포츠산업 '생태계 파괴자' 된 빈살만[글로벌스트롱맨]](https://image.edaily.co.kr/images/Photo/files/NP/S/2023/11/PS23110500115t.jpg)

![[포토] 폭염 속 휴식취하는 건설 근로자](https://image.edaily.co.kr/images/Photo/files/NP/S/2023/08/PS23080100718t.jpg)

![[포토]2024 건설의 날 기념식](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062600803t.jpg)

![[포토]복지위 전체회의, '질의하는 서영석 의원'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062600702t.jpg)

![[포토]OB맥주 카스, 파리에서 만나요!](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062600578t.jpg)

![[포토] 경실련, "공시가격 바로 잡아라~"](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062600422t.jpg)

![[포토]고군택,저 언덕 넘어 가보자](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062500175t.jpg)

![[포토]맑은 하늘](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062500943t.jpg)

![[포토]한자리에 선 한일 재무장관들](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062500875t.jpg)

![[포토]디지털금융정책관 현판식](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062500723t.jpg)

![[포토]마운트곡스에 운 비트코인…6만달러도 '위태'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062500700t.jpg)

![[포토]국토위, '발언하는 문진석 의원'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/06/PS24062500663t.jpg)